Tärkeimmät oppimispisteet

- Ohjelmistot, jotka käyttävät tekoälyä ihmisten profiloimiseen, herättävät huolta yksityisyydestä.

- Cryfe yhdistää käyttäytymisanalyysitekniikat tekoälyyn.

- Kiinalainen Alibaba joutui äskettäin kritisoimaan sen sanottua, että sen ohjelmisto voisi havaita uiguurit ja muut etniset vähemmistöt.

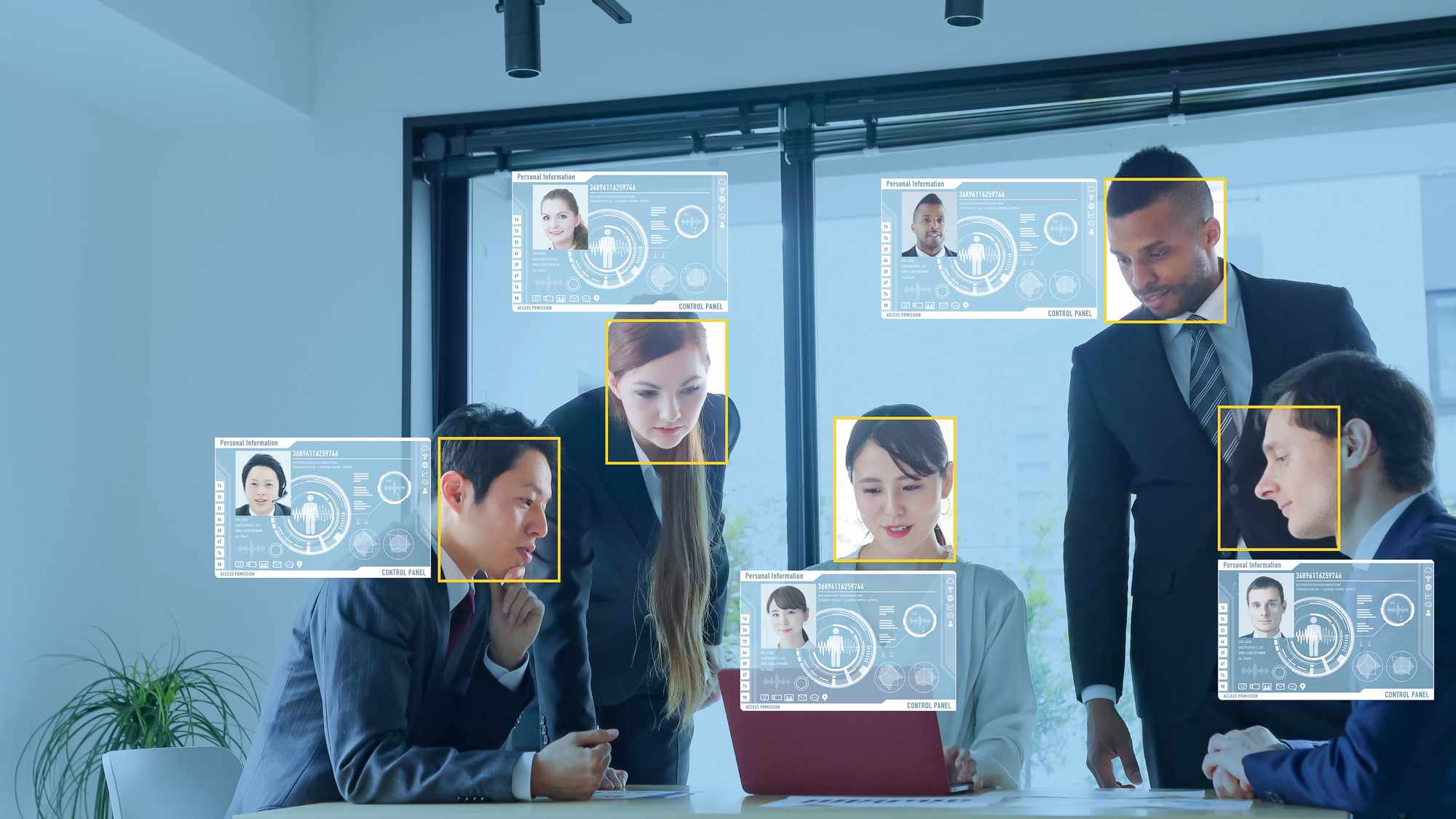

Uudet tekoälyohjelmistot, jotka on tarkoitettu työnantajille profiloimaan työntekijöitään, herättävät huolta yksityisyydestä. Uusi ohjelmistoalusta nimeltä Cryfe yhdistää käyttäytymisanalyysitekniikat tekoälyyn. Kehittäjä väittää, että pieniä vihjeitä analysoimalla ohjelmisto voi paljastaa ihmisten aikeet haastattelujen aikana. Mutta jotkut tarkkailijat sanovat, että Cryfe ja muut käyttäytymistä analysoivat ohjelmistot voivat loukata yksityisyyttä. «Yritykset luottavat yhä enemmän tekoälyyn profiloinnissa», sanoi tekoälyasiantuntija Vaclav Vincale sähköpostihaastattelussa. «Mutta edes ihmiset, jotka koodaavat näitä algoritmeja, puhumattakaan asiakaspalvelusta, joka tavoitti sinut puhelimitse, eivät voineet kertoa, miksi he antavat tietyn suosituksen.»

Enemmän kuin sanat

Cryfen on kehittänyt sveitsiläinen yritys, jonka työntekijät FBI on kouluttanut profilointitekniikoihin. «Kaikessa ihmisten välisessä viestinnässä Cryfe ei vain kuuntele sanoja, vaan myös tunnistaa muita ihmisten lähettämiä signaaleja, kuten tunteita, mikroilmaisuja ja kaikkia eleitä», sanoi Cryfen perustaja Caroline Matteucci sähköpostihaastattelussa. «Tämä mahdollistaa esimerkiksi keskustelukumppanimme todellisen persoonallisuuden etsimisen rekrytointiprosessin aikana.» Matteucci sanoi, että käyttäjien yksityisyys on suojattu, koska yritys on avoin ohjelmistonsa toiminnasta. «Käyttäjän on hyväksyttävä ehdot ennen alustan käyttöä», hän sanoi. «Siellä on määrätty, että käyttäjä ei saa missään olosuhteissa lähettää haastattelua analysoitavaksi ilman keskustelukumppanin kirjallista suostumusta.» Cryfe ei ole ainoa tekoälyllä toimiva ohjelmisto, joka väittää analysoivansa ihmisten käyttäytymistä. Mukana on myös Humantic, joka väittää analysoivansa kuluttajien käyttäytymistä. «Humanticin uraauurtava teknologia ennustaa jokaisen käyttäytymisen ilman, että heidän tarvitsee koskaan suorittaa persoonallisuustestiä», yhtiön verkkosivujen mukaan.

Yritys väittää käyttävänsä tekoälyä luomaan hakijoiden psykologisia profiileja niiden sanojen perusteella, joita he käyttävät ansioluetteloissa, saatekirjeissä, LinkedIn-profiileissa ja missä tahansa muussa lähettämässään tekstissä. Käyttäytymisohjelmistot ovat joutuneet oikeudellisiin ongelmiin aiemmin. 2019, Bloombergin laki raportoi, että Equal Employment Opportunity Commission (EEOC) on tutkinut tapauksia väitetystä laittomasta syrjinnästä, joka johtuu algoritmien tukemista henkilöstöön liittyvistä päätöksistä. «Tämä kaikki on selvitettävä, koska rekrytoinnin tulevaisuus on tekoäly», asianajaja Bradford Newman kertoi Bloombergille. Jotkut tarkkailijat ovat eri mieltä yritysten kanssa, jotka käyttävät käyttäytymisen seurantaohjelmistoja, koska se ei ole tarpeeksi tarkka. Nigel Duffy, asiantuntijapalveluyrityksen EY:n globaali tekoälyn johtaja, sanoi haastattelussa: Tietoviikko että häntä häiritsevät ohjelmistot, jotka käyttävät sosiaalisen median tietokilpailuja ja vaikuttavat havaitsemiseen. «Luulen, että siellä on todella vakuuttavaa kirjallisuutta vaikutusten havaitsemismahdollisuuksista, mutta ymmärrän, että tapa, jota usein toteutetaan, on melko naiivi», hän sanoi. «Ihmiset tekevät johtopäätöksiä, joita tiede ei todellakaan tue» [such as] päättää, että joku on mahdollisesti hyvä työntekijä, koska hän hymyilee paljon, tai päättää, että joku pitää tuotteistasi, koska hän hymyilee paljon.»

Kiinalaisten yritysten kerrotaan profiloivan vähemmistöjä

Jotkut ihmisoikeusjärjestöt sanovat, että käyttäytymisen jäljittämisellä voi olla myös synkempiä tarkoituksia. Kiinassa verkkokauppajätti Alibaba aiheutti hiljattain kohua, kun se väitti, että sen ohjelmisto voisi havaita uiguurit ja muut etniset vähemmistöt.

New York Times kertoi, että yhtiön pilvipalveluissa oli ohjelmistoja, jotka skannasivat kuvia ja videoita. Mutta edes ihmiset, jotka koodaavat näitä algoritmeja… eivät voineet kertoa, miksi he antavat tietyn suosituksen.

Washington Post Se raportoi myös äskettäin, että Huawei, toinen kiinalainen teknologiayritys, oli testannut ohjelmistoja, jotka voivat varoittaa lainvalvontaviranomaisia, kun sen valvontakamerat havaitsivat uiguurien kasvoja. Huawein vuoden 2018 patenttihakemuksessa väitetään, että «jalankulkijan ominaisuuksien tunnistaminen on erittäin tärkeää» kasvojentunnistustekniikassa. «Kohdeobjektin ominaisuudet voivat olla sukupuoli (mies, nainen), ikä (esim. teini-ikäiset, keski-ikäiset, vanhat) [or] rotu (han, uiguurit), sovellus sanoi. Huawein tiedottaja kertoi CNN Businessille, että etnisen alkuperän tunnistamisominaisuuden «ei olisi koskaan pitänyt olla osa sovellusta.» Kun seuraavan kerran menet haastatteluun, et ehkä koskaan tiedä kuka tai mitä sinä analysoit.